Escrito por Brian Bergstein

Você provavelmente já ouviu versões de cada uma das seguintes ideias.

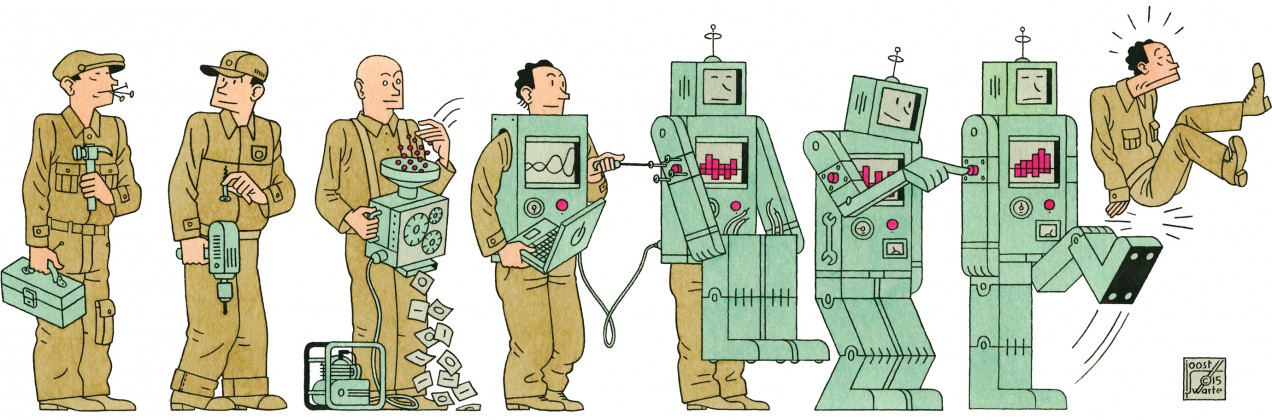

1. Com os computadores se tornando cada vez mais "competentes" em se orientar e dirigir, na compreensão da fala e de outras tarefas, mais e mais empregos podem ser automatizados em breve, mais do que a sociedade está preparada para lidar;

2. Melhorias nas habilidades dos computadores irão acumular até que as máquinas sejam muito mais inteligentes do que as pessoas. Essa “superinteligência” fará com que o trabalho humano seja desnecessário. Na verdade, é melhor esperarmos que as máquinas não nos eliminem completamente, acidentalmente ou de propósito.

Isso é complicado. Mesmo que o primeiro cenário já esteja em andamento, ele não levará necessariamente ao segundo cenário. Essa segunda ideia, apesar de ser uma obsessão de algumas pessoas muito conhecedoras e ponderadas, baseia-se em enormes suposições. No mínimo, é uma distração assumir mais responsabilidade pelos efeitos do nível de automação atual e lidar com a concentração de poder no setor de tecnologia.

Para realmente ver o que está acontecendo, temos que ser claros sobre o que foi alcançado - e o que ainda está longe de ser resolvido - na inteligência artificial.

Senso comum

Os desenvolvimentos mais impressionantes da computação nos últimos anos - carros que dirigem a si próprios, máquinas que reconhecem imagens e fala com precisão, computadores que vencem os jogadores humanos mais brilhantes de jogos complexos como o Go - derivam de avanços em um ramo específico da IA: a adaptação do aprendizado de máquinas. Como o cientista da computação da Universidade de Toronto, Hector Levesque, coloca em seu livro Common Sense, The Turing Test e Quest for Real AI, a idéia por trás do aprendizado adaptativo de máquina é “fazer um sistema de computador aprender algum comportamento inteligente treinando-o grandes quantidades de dados ”.

É incrível que uma máquina possa detectar objetos, traduzir entre idiomas e até escrever código de computador depois de receber exemplos desses comportamentos, em vez de precisar ser programados com antecedência. Isso não foi possível até cerca de uma década atrás, porque anteriormente não havia dados digitais suficientes para fins de treinamento e, mesmo que houvesse, não havia potência suficiente para computar tudo. Depois que os computadores detectam padrões nos dados, os algoritmos em software os levam a inferir esses padrões e a agir sobre eles. Isso é o que está acontecendo em um carro quando ele, analisando as entradas de vários sensores, define rotas e riscos e em uma máquina que processa cada movimento em milhões de jogadas possíveis do "Go".

Como as máquinas podem processar quantidades sobre-humanas de dados, você pode ver por que elas podem dirigir com mais segurança do que as pessoas na maioria das circunstâncias assim como explica por que elas podem vencer os campeões do Go. É também por isso que os computadores estão ficando ainda melhores em coisas que são completamente impossíveis para as pessoas, como correlacionar seu genoma e dezenas de outras variáveis biológicas com as drogas mais propensas a curar seu câncer.

Mesmo assim, tudo isso é uma pequena parte do que poderia ser razoavelmente definido como inteligência artificial real. Patrick Winston, professor de IA e ciência da computação no MIT, diz que seria mais útil descrever os desenvolvimentos dos últimos anos como tendo ocorrido em "estatísticas computacionais" do que em IA. Um dos principais pesquisadores da área, Yann LeCun, diretor de AI do Facebook, disse em uma conferência do Future of Work no MIT em novembro que as máquinas estão longe de ter "a essência da inteligência". Isso inclui a capacidade de entender o mundo físico. bem o suficiente para fazer previsões sobre aspectos básicos - observar uma coisa e depois usar o conhecimento de fundo para descobrir que outras coisas também devem ser verdadeiras. Outra maneira de dizer isso é que as máquinas não têm bom senso.

O computador que ganha no Go está analisando dados para padrões. Não faz ideia que está jogando o Go em vez do golfe.

Isso não é apenas uma queixa semântica. Há uma grande diferença entre uma máquina que exibe "comportamento inteligente", não importa o quão útil seja esse comportamento e que seja realmente inteligente. Agora, vamos admitir que a definição de inteligência é obscura. E, à medida que os computadores se tornam mais poderosos, é tentador afastar os postes da baliza e redefinir a inteligência, de modo que permaneça algo que ainda não se pode dizer que as máquinas possuam.

Mas, mesmo assim, vamos lá: o computador que ganha no Go está analisando dados para padrões. Não faz ideia que está a jogar o Go em oposição ao golfe, ou o que aconteceria se mais de metade de um tabuleiro fosse empurrado para além da margem de uma mesa. Quando você solicita ao Alexa da Amazon para reservar uma mesa em um restaurante que você nomeou, seu sistema de reconhecimento de voz, muito preciso por aprendizado de máquina, economiza o tempo de inserir uma solicitação no sistema de reservas do Open Table. Mas Alexa não sabe o que é um restaurante ou o que é comer. Se você pediu para reservar uma mesa para dois às 18h. na Mayo Clinic, ela "tentaria".

É possível dar às máquinas o poder de pensar, como John McCarthy, Marvin Minsky e outros criadores de AI pretendiam há 60 anos? Levesque explica que, para isso, seria necessário imbuir computadores com bom senso e capacidade de utilizar de forma flexível o conhecimento de fundo sobre o mundo. Talvez seja possível. Mas não há um caminho claro para fazer isso acontecer. Esse tipo de trabalho esta distante o suficiente das descobertas dos últimos anos em busca de aprendizado de máquina para passar por um nome diferente: GOFAI, abreviação de "boa e velha inteligência artificial".

Se você está preocupado com computadores oniscientes, leia Levesque sobre o tema GOFAI. Os cientistas da computação ainda não responderam a questões fundamentais que ocuparam McCarthy e Minsky. Como um computador pode detectar, codificar e processar não apenas fatos crus, mas ideias e crenças abstratas, que são necessárias para intuir verdades que não são explicitamente expressas?

Levesque usa este exemplo: suponha que eu pergunte como um crocodilo funcionaria na corrida de obstáculos. Você sabe, pela sua experiência do mundo, que os crocodilos não conseguem ultrapassar as traves altas, então você sabe que a resposta para a pergunta é uma variante de "MUITO MAL".

E se você tivesse que responder a essa pergunta da maneira que um computador pode? Você poderia escanear todo o texto do mundo para os termos “crocodilo” e “corrida de obstáculos”, não encontrar exemplos de palavras sendo mencionadas juntas (além do que existe agora, em referências ao trabalho de Levesque), e então presumir que um crocodilo nunca competiu EM UMA PISTA DE OBSTÁCULOS. Então você pode descobrir que seria impossível um crocodilo fazer isso. Bom trabalho - desta vez. Você teria chegado à resposta certa sem saber por quê. Você teria usado um método defeituoso e frágil que provavelmente levaria a erros ridículos.

Assim, enquanto as tecnologias de aprendizado de máquina estão possibilitando automatizar muitas tarefas que os humanos tradicionalmente fizeram, há limites importantes para o que essa abordagem pode fazer sozinha - e há boas razões para esperar que o trabalho humano seja necessário por um tempo muito longo.

Reducionismo

Espere, você pode dizer: só porque ninguém tem a menor idéia agora sobre como fazer com que as máquinas façam um raciocínio sofisticado não significa que é impossível. E se máquinas um tanto inteligentes puderem ser usadas para projetar máquinas ainda mais inteligentes, e assim por diante, até que haja máquinas suficientemente potentes para modelar todos os últimos sinais elétricos e mudanças bioquímicas no cérebro? Ou talvez outra forma de criar uma inteligência flexível seja inventada, mesmo que não seja muito semelhante a cérebros biológicos. Afinal, quando você olha profundamente (realmente, realmente, realmente profundamente), a inteligência surge de arranjos particulares de quarks e outras partículas fundamentais em nossos cérebros. Não há nada a dizer que tais arranjos só são possíveis dentro de material biológico feito de átomos de carbono.

Este é o argumento que passa pela Life 3.0: Ser Humano na Era da Inteligência Artificial, pelo professor de física do MIT, Max Tegmark. Fica claro em prever quando máquinas verdadeiramente inteligentes chegarão, mas ele sugere que é apenas uma questão de tempo, porque os computadores tendem a melhorar a taxas exponenciais (embora isso não seja necessariamente verdadeiro - veja “Os Sete Pecados Mortais das Previsões da IA”). Ele está geralmente empolgado com a perspectiva, porque máquinas conscientes podem colonizar o universo e garantir que ele ainda tenha significado mesmo depois que nosso sol morre e os humanos são extinguidos.

No momento, muitas coisas podem dar errado - e estão dando errado - com o uso de computadores que ficam bem aquém da IA do estilo HAL. Pense na forma como os sistemas que influenciam a concessão de empréstimos ou fiança incorporam preconceitos raciais e outros fatores discriminatórios. Ou hoaxes que voam no Google e no Facebook. Ou ataques cibernéticos automatizados.

Em WTF ?: Qual é o futuro e por que é com a gente, Tim O'Reilly, um editor e investidor de tecnologia, vê um problema ainda maior: a automação está alimentando um sistema míope de capitalismo acionário que recompensa uma pequena porcentagem de investidores à custa de quase todos os outros. Claro, a IA pode ser usada para ajudar as pessoas a resolver problemas realmente difíceis e aumentar a produtividade econômica. Mas isso não acontecerá muito, a menos que as empresas invistam nessas oportunidades.

Em vez disso, argumenta O'Reilly, o imperativo implacável de maximizar retornos para os acionistas torna as empresas mais propensas a usar a automação apenas como uma maneira de economizar dinheiro. Por exemplo, ele denuncia como as grandes corporações substituem a equipe em tempo integral por trabalhadores temporários de baixo salário cujos horários são manipulados por softwares que os monitoram, diz O'Reilly, como “componentes descartáveis”. A economia resultante, diz ele, é muito grande. Freqüentemente arado em recompras de ações e outros legerdemain financeiros, em vez de pesquisa e desenvolvimento, investimentos de capital, treinamento de trabalhadores e outras coisas que tendem a criar bons novos empregos.

Isso é contra os interesses corporativos a longo prazo, porque os trabalhadores bem pagos de hoje podem se dar ao luxo de serem clientes para os produtos de amanhã. Mas as empresas são enganadas pelas recompensas pelo corte de custos de curto prazo, que O'Reilly chama de "os algoritmos não examinados que governam nossa economia". E, acrescenta, "apesar de toda a conversa sobre desorganização, o Vale do Silício é muitas vezes dominado para esse sistema. ”

O que fazer? Entre outras coisas, O'Reilly sugere aumentar o salário mínimo e taxar os robôs, as emissões de carbono e as transações financeiras. Em vez de buscar IPOs e bancar o jogo de Wall Street, acredita ele, os empreendedores de tecnologia devem disseminar riqueza com outros modelos, como cooperativas de membros e estruturas de investimento que recompensem o pensamento de longo prazo. Quanto a uma renda básica universal, uma idéia antiga surgindo novamente por causa do medo de que os computadores tornem o trabalho humano praticamente inútil, O'Reilly parece aberto à possibilidade de que isso seja necessário algum dia. Mas ele não está chamando por isso ainda. De fato, parece um fracasso da imaginação supor que o próximo passo de onde estamos agora é simplesmente desistir da perspectiva de que a maioria das pessoas tenha empregos.

No clima político de hoje, os impostos aumentam e outras medidas que O'Reilly advoga podem parecer tão absurdas quanto um computador que engana um cara para pensar que sua esposa ressuscitou. Mas pelo menos O’Reilly está preocupado com os problemas certos. Muito antes que alguém descubra como criar uma superinteligência, o senso comum - a versão humana - pode nos dizer que a instabilidade já causada pela desigualdade econômica só piorará se a inteligência artificial for usada para restringir os fins. Uma coisa é certa: não obteremos superinteligência se o Vale do Silício for invadido por uma horda com forcados.

Brian Bergstein é editor colaborador da MIT Technology Review e editor do Neo.Life.

Nenhum comentário:

Postar um comentário